La notion d’un « ingénieur logiciel IA » passe rapidement du conceptuel au concret, transformant profondément le paysage du développement logiciel tel que nous le connaissons.

Le progrès technologique a toujours facilité la voie pour les ingénieurs logiciels :

- Devin a fait ses débuts comme le premier ingénieur logiciel IA l’année dernière, marquant ce changement de paradigme.

- Cursor émerge en tant que digne alternative au VS Code traditionnel, intégrant l’IA de manière fluide dans les environnements de développement.

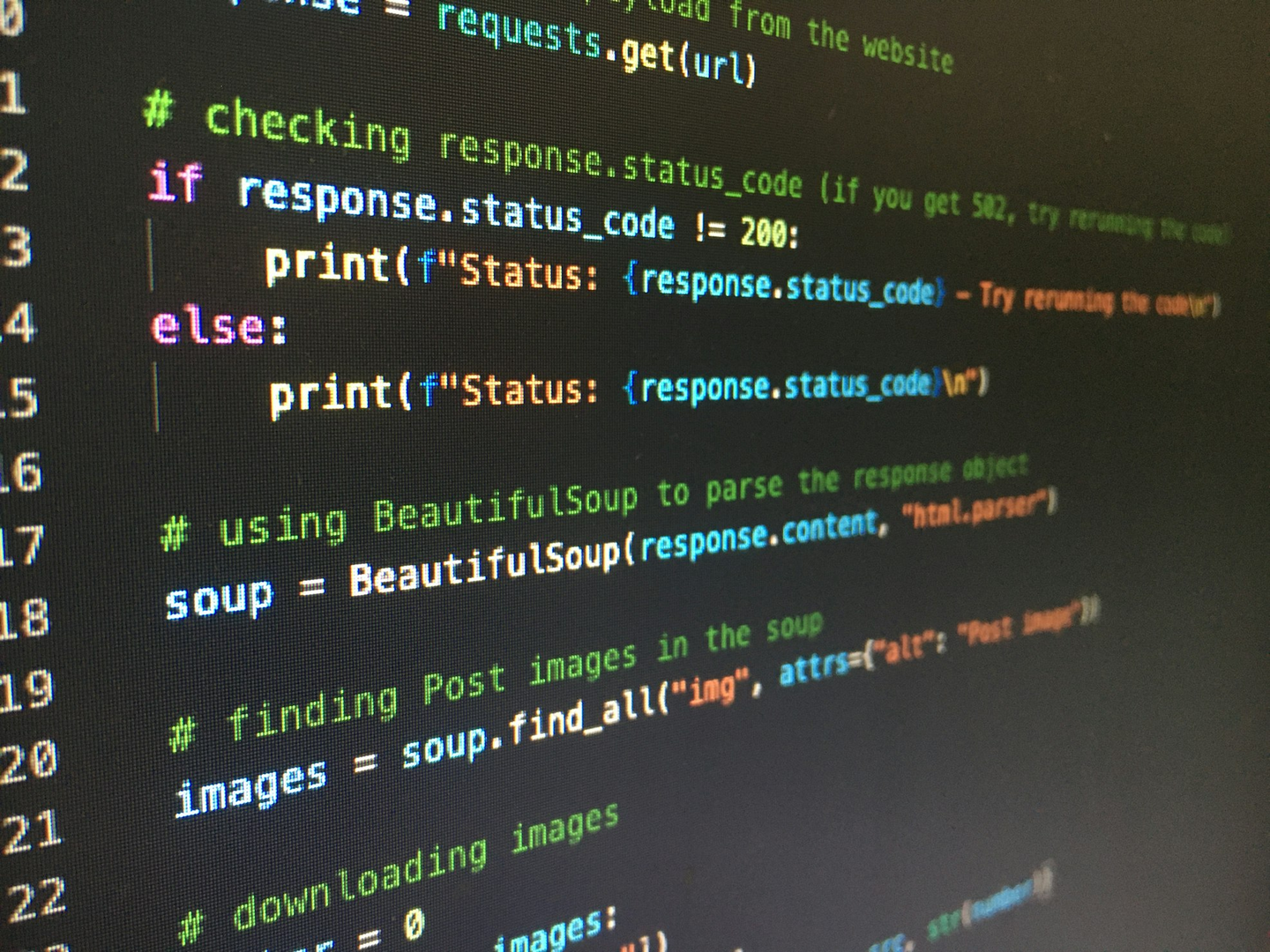

- Pensez à GPT-4 et Claude, qui offrent une assistance remarquable pour le codage et la correction des bugs.

Ces avancées indiquent une trajectoire où l’ingénierie logicielle devient de plus en plus intuitive, encouragée par la quête humaine continue dans le raisonnement des LLM.

Ingénieurs Logiciels IA vs. LLM Traditionnels

Qu’est-ce qui distingue un ingénieur logiciel IA d’un LLM plus simple ? Certes, les LLM ont la capacité d’écrire du code. Pourtant, il y a une profondeur ici qui mérite d’être explorée :

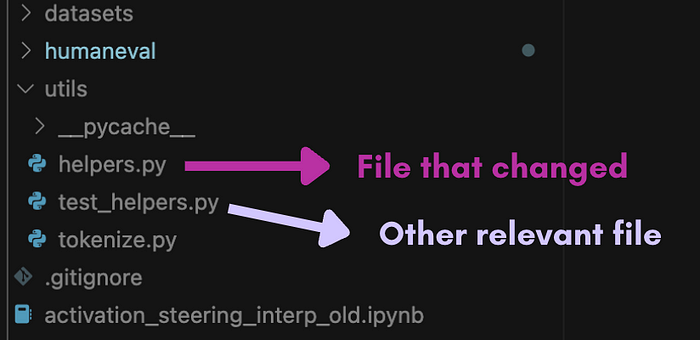

Un ingénieur logiciel IA ne se contente pas d’écrire du code – il navigue dans un dépôt entier, discernant quels fichiers modifier en fonction d’une tâche donnée.

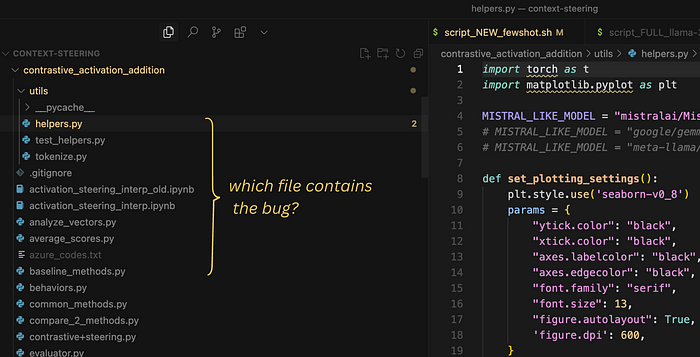

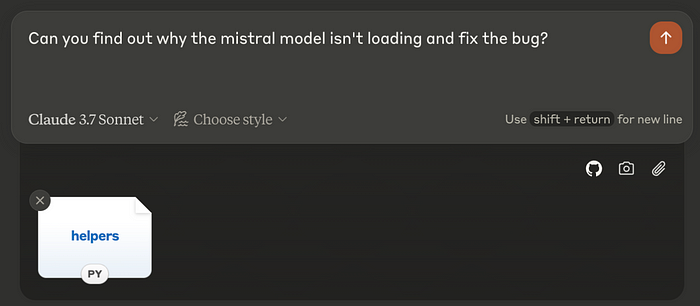

Imaginez un projet IA embourbé par un problème de chargement lors de la sélection du modèle Mistral :

Un ingénieur logiciel doit identifier le fichier erroné et appliquer la correction. Cela pourrait commencer par un examen de l’emplacement du chargeur de modèle, et si des problèmes plus profonds existent ailleurs, plonger dans ces dépendances.

Ce niveau d’inspection holistique dépasse un LLM régulier, qui nécessite une direction explicite vers le fichier contenant le problème avant d’essayer des réparations.

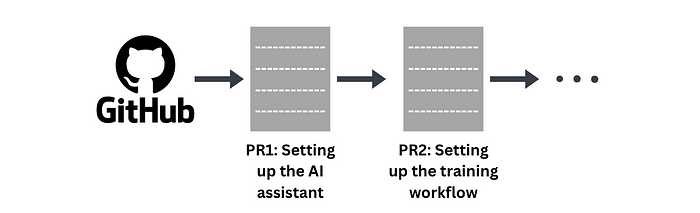

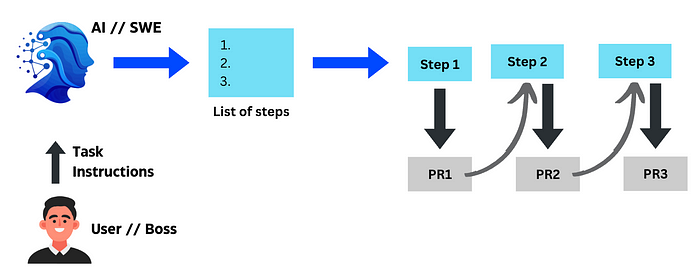

Un ingénieur logiciel IA, comme son homologue humain, crée itérativement des PR (demandes de tirage) pour résoudre les différents aspects de la base de code.

Le codage de ces améliorations peut être soit un processus autonome ou guidé par des invites utilisateur.

Forger un Ingénieur Logiciel IA (SWE)

En tenant compte des avancées récentes comme le modèle DeepSeek, vous pourriez vous demander si les LLM équipés d’Apprentissage par Renforcement (RL) peuvent transcender en ingénieurs logiciels compétents. Je vous invite à consulter mon blog précédent illustrant la portée polyvalente de l’entraînement en RL.

Découvrez les Opportunités de Recherche Inexploitées avec DeepSeek-R1

Avec la capacité du RL à se résoudre sans instruction explicite, nous devons nous demander :

Le RL pourrait-il également améliorer nos tâches d’ingénierie logicielle ?

Définition de la Tâche

Notre mission est de créer une IA capable d’appliquer automatiquement les ajustements nécessaires à un dépôt – exactement comme un ingénieur qualifié le ferait.

Le Voyage pour Former un SWE IA

Pour former une IA comme DeepSeek, des raffinements de pipeline RL identiques sont appliqués :

Cette technique universellement adaptable, perfectionnant d’abord le raisonnement, suggère une efficacité amplifiée dans divers domaines, y compris nos ambitions SWE.

Est-ce que se concentrer sur des scénarios de codage explicites embraserait des résultats encore meilleurs ?

Assemblage des Données

La collecte de données s’élève comme la première étape, destinée à illuminer le LLM avec des instructions sur la révision :

- Configurations de code actuelles

- Fonctions nécessitant une transformation

Où résident de telles données ?

Les PR Git fournissent une mine d’informations :

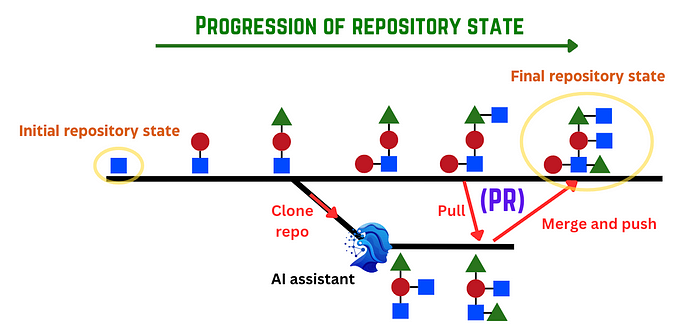

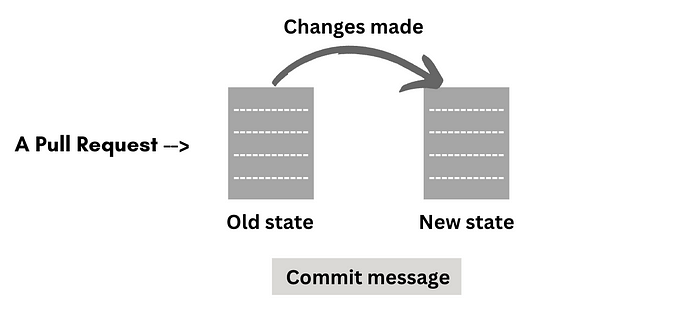

Une PR Git orchestre la fusion des modifications proposées à la branche. Un développeur exécute des modifications, les documente via des messages de commit, avant de fusionner avec le dépôt principal, capturant la chronique de l’évolution avant l’interaction de l’IA.

En récoltant de nombreuses PR de dépôts publics, le fondement est posé pour enseigner au LLM l’innovation en matière de code en tenant compte de la tâche et de l’état antérieur.

Incitation Ingénieuse

Face aux complexités des ensembles de données, une approche stratégique pour inciter les LLM pendant la formation se pose :

Offrir des extraits – fichiers modifiés avant/après le commit et pertinents.

Même les fichiers inchangés, interconnectés par la stabilité de l’écosystème, offrent un apprentissage contextuel précieux.

Calcul de la Récompense

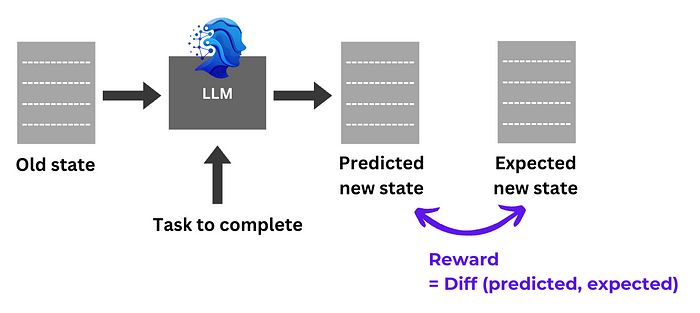

En façonnant les incitations, nous simplifions : contrastons la sortie du LLM avec l’état de fichier PR attendu. Une ressemblance plus proche équivaut à des récompenses plus riches.

Initiatives de Formation

Le processus central se déroule avec une entrée de données, obtenant les sorties du LLM, une évaluation subséquente et des récompenses dirigées vers le raffinement des politiques garantissant la cohérence.

Amplification de l’Efficacité

Apprentissage en Parcours

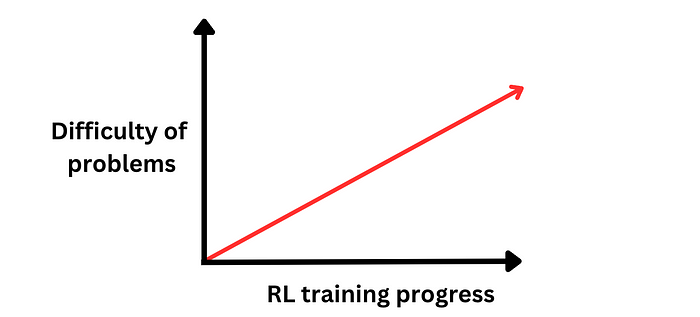

Un apprentissage en couches de difficulté dans la boucle d’apprentissage du RL enrichit l’efficacité en reflétant l’illumination académique progressive :

Ordonner les PRs – des changements minimalistes aux calamités complexes – pourrait favoriser des avancées en raisonnement nuancé.

Affinage des Données et des Récompenses

Des données plus propres et des récompenses plus intelligentes sous-tendent des sauts potentiels dans la compétence des LLM :

- Qualité des Données : S’assurer que les PR reflètent des habitudes d’ingénierie idéales exige des ensembles de données triés sur le volet, un défi dans l’immensité des dépôts en ligne.

- Précision de la Récompense : La déviation entre le LLM et le dépôt pourrait engendrer un renforcement négatif, même lorsque la solution du LLM excelle, déformant la guidance.

Sans aucun doute, le raffinage des données et des incitations émerge comme des terrains riches pour les futurs débats et innovations.

Conclusion

La vision d’un ingénieur logiciel IA n’est pas lointaine mais presque à notre portée, avec une accessibilité open-source incitant les développeurs du monde entier.

Explorer les couches de conception d’ingénieurs IA révèle de multiples efficacités encore à dénicher. Alors que le domaine s’épanouit, semer la recherche dans les LLM augmentés par le RL promet des avancées inestimables. Adoptez ce domaine émergent ; c’est un moment opportun pour plonger, tout comme je le suis cette année.